Sireni dezinformace

Existuje hodně různých nástrojů, jež se využívají během informačních válek, ale jeden z nejstarších a nejefektivnějších je bodová injekce dezinformací v konkrétní skupinu. Na zkoumání tohoto nástroje je zaměřená má simulace. Předpokládá se že nepřítel zvolil jako cíl malou a pevně propojenou skupinu uživatelů (například, internet-forum). Musíme být připravený, a proto se pokusíme zjistit, jaká minimální konfigurace je dostatečná pro minimalizaci šíření dezinformací. Sledujeme výsledek jednotlivé, neopakované "injekci", která potenciálně nacílená na přípravu auditoria k následujícímu po injekci rozhodování, buď marketingovému nebo politickému.

Contents

Definice problému

Dezinformace jsou falešné nebo zavádějící informace, které jsou šířeny, často s úmyslem ovlivnit veřejné mínění nebo skryt politickou pravdu. Problém dezinformace je zvlášť palčivý v dnešní digitální éře, kdy je velké množství informací a dezinformací sdíleno online přes sociální média a jiné platformy.

Šíření dezinformací má vážné důsledky. Dezinformace mohou narušovat demokratické procesy, šířit nenávist a konflikty a narušovat veřejné zdraví. Například dezinformace o COVID-19 vedly k závažným zdravotním rizikům a zmatení ve veřejnosti. Můžou být využité pro podporu strategií velkých byznysů a států.

V kontextu tohoto problému je cílem mé simulace zkoumat, jak se dezinformace šíří v sociální síti, a jak mohou administrátoři (AI a lidé) rozpoznat a odstraňovat tyto dezinformace. Mým cílem je lépe pochopit, jak dezinformace ovlivňují jednotlivé uživatele a jak konfigurace administrátorů může pomoct minimalizovat rozsah šíření dezinformací.

Metóda

K řešení tohoto problému používám agent-based modelování v NetLogo. Tento přístup mi umožňuje simulovat chování jednotlivých agentů a sledovat, jak se dezinformace šíří v sociální síti.

Model

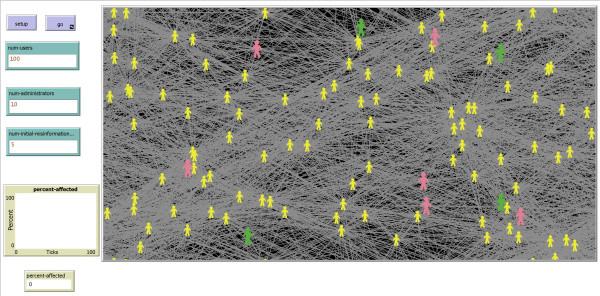

Po zmáčknuti "setup" se vytvoří model sociálních spojení uživatelů a administrátorů. Uživatele mají náhodný počet spojení v rámci 1-100, administrátor-člověk je spojen s 10% uživatelů, administrátor-AI s 30%.

Pravidla a postup simulace: 1. Agenti provádějí své akce. Když přijmou dezinformaci, tak podle svých parametrů rozhodnou, jestli ji předají dál náhodnému počtu sousedů (v rámci od 1 do všech sousedů) nebo se stanou "informovaní", což znamená že rozpoznali dezinformaci a nebudou ji předávat dál. 2. Administrátoři provádějí své akce: když administrátor přijme dezinformaci, nejdřív vypočítá jestli ji rozpozná. Jestli ano, tak odstraní ji u všech spojených s nim uživatelů způsobem, že je "proinformuje". 3. Krok se končí a opakujeme znovu.

Parametry agentů

Typy agentů: Jsou zde dva hlavní typy agentů - uživatelé a administrátoři. Uživatelé jsou ti, kteří sdílejí a přijímají informace. Administrátoři jsou ti, kdo ji odstraňují.

- Charakteristiky uživatelů: Tito agenti jsou dále rozděleni na základě demografických údajů, jako je věk, vzdělání, politická orientace, takže počet spojení a počet už sdílených odkazů. Podle těchto parametrů se určuje jejich náchylnost k přijetí a šíření takových informací.

-- Věk. Skupina 18-29 = 0,1 (koeficient pravděpodobností šíření dezinformace). Skupina 30-44 = 0,2. Skupina 45-65 = 0,3. Skupina 65-100 = 0,7.

-- Vzdělání: Střední škola - 0,4. Vysoká škola - 0,2.

-- Politická orientace: Konzervativní - 0,8. Ostatní - 0,2.

-- Počet už sdílených odkazů: 0-2000 = 0,4. 2000-4000 = 0,1.

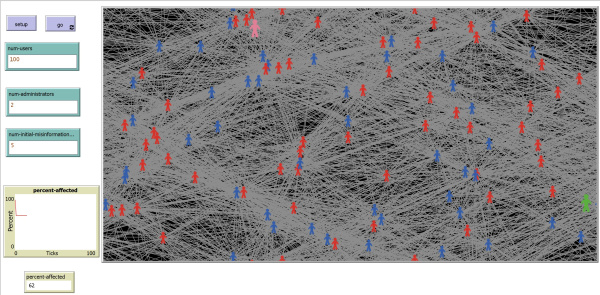

-- Barva: Žlutá - neovlivněn dezinformací, Červená - rozhodl ji šířit, Modrá - informován a nešíří ji dál.

- Charakteristiky administrátorů: člověk (zelený) nebo AI (růžový).

-- Člověk: reakční doba = 1 tick (může odstranit dezinformace jen v příští tick). Pravděpodobnost rozpoznání dezinformací - 0,7.

-- AI: reakční doba = 0 (může odstraňovat dezinformace hned). Pravděpodobnost rozpoznání dezinformací - 0,3.

Prostredí

Prostředí je sociální síť, konkrétně internet-forum nebo skupina uživatelů v sociální síti. Pro zjednodušení jsem odebral funkčnost rekomendace dezinformací pomocí algoritmů sociální síti.

Můžeme kontrolovat a měnit tři základní parametry simulace: počet uživatelů, administrátorů a počátečních zdrojů dezinformací.

Výsledky

1. Začal jsem s konfiguraci Uživatele (dál - U) = 100, Administrátoři (dál - A) = 0, zdroje dezinformací (dál - Z) = 5. Ukazuje se že model se vybalancuje na ~90% ovlivněných uživatelů (ty, kteří rozhodli dezinformace šířit). To znamená že sociální sítě bez moderace určitě nejsou schopni čelit dezinformacím.

2. Když dám U = 100, A = 5, Z = 5, tak výsledek je ~30%

3. V případě, že U = 100, A = 10, Z = 5, tak výsledek je ~10%

4. Jestli U = 100, A = 15, Z = 5, tak výsledek je ~5%

5. V případě, že U = 100, A = 20, Z = 5, tak výsledek je ~0%, což znamená že taková proporce už skoro vždycky schopna zajistit úplné blokování šíření dezinformací. Ale takže nebude ekonomický vhodná, proto zvolíme konfiguraci č. 4, která je dostatečná pro naše účely.

Zkontrolujeme proporci, dáme U = 200, A = 30, Z = 10, a zjistíme že výsledek je stejně ~5%.

Záver

Splnil jsem postavený cíl: pochopil jsem líp jak se šíří dezinformace na sociálních sítích a našel jsem optimální konfiguraci U, A, i Z pro čelení podobným způsobům ovlivnění mínění.

Z mé simulace vyplývá, že efektivním způsobem, jak minimalizovat šíření dezinformací v sociálních sítích, je zavést určitý počet administrátorů (lidí a AI) s určitými charakteristikami.

Model jasně ukazuje, že bez přítomnosti administrátorů bude převažující většina uživatelů náchylná k šíření dezinformací. Na druhou stranu, s rostoucím počtem administrátorů se snižuje procento uživatelů, kteří jsou nakonec ovlivněni dezinformacemi.

Optimální konfigurace, kterou jsem našel, je, že pro 100 uživatelů by mělo být asi 15 administrátorů schopných účinně blokovat šíření dezinformací. Tato konfigurace však může být nákladná z hlediska provozu a správy sítě, a proto je důležité najít správnou rovnováhu mezi náklady a účinností.

Můj model je zjednodušený a nebere v úvahu některé další faktory, které mohou ovlivnit šíření dezinformací, jako je například algoritmy sociální sítě pro doporučování obsahu. Nicméně poskytuje užitečný rámec pro další výzkum a zkoumání v této oblasti.